Googles neuer Meilenstein: Quantencomputer machen Fehler, aber immer weniger

Weil Quantencomputer besonders anfällig für Rechenfehler sind, stockt die Entwicklung leistungsstarker Exemplare. Nun hat Google eine erste Hürde zu fehlertoleranten Quantenrechnern genommen. Es bleibt aber noch viel zu forschen.

Dieser Artikel ist zuerst in der Neuen Zürcher Zeitung erschienen.

Quantencomputer gelten als das nächste „große Ding“ in der Informationstechnik: Sie sollen praxisrelevante Probleme schnell lösen, an denen selbst die größten Supercomputer Jahrzehnte kauen würden. Tech-Riesen wie Intel, IBM oder Google entwickeln Prototypen. Interessierte Anwender probieren an diesen einfachen Quantencomputern herum, zum Beispiel, ob sich Lieferketten damit optimieren lassen. Regierungen fördern die Entwicklung mit Milliarden Dollars oder Euros.

Dabei bleibt ein grundlegendes Problem ungelöst, trotz intensiver Forschung: Die Fehlerkorrektur. Denn Quantenrechner sind äußerst anfällig für Fehler, die noch dazu schwer zu ermitteln und zu korrigieren sind. Forscher stecken in einem Teufelskreis.

Für die Fehlerkorrektur braucht der Quantenrechner zusätzliche Rechenressourcen. Und zwar umso mehr, je stärker man Fehler unterdrücken möchte. Je komplexer die zu lösende Aufgabe, desto niedriger muss die Fehlerrate sein. Das dazu nötige Vielfache an Rechenkraft ist aber ebenfalls fehleranfällig. Unterm Strich entstehen so mehr neue Fehler, als korrigiert werden.

In der Stärke von Quantencomputern liegt gleichzeitig ihre Schwäche

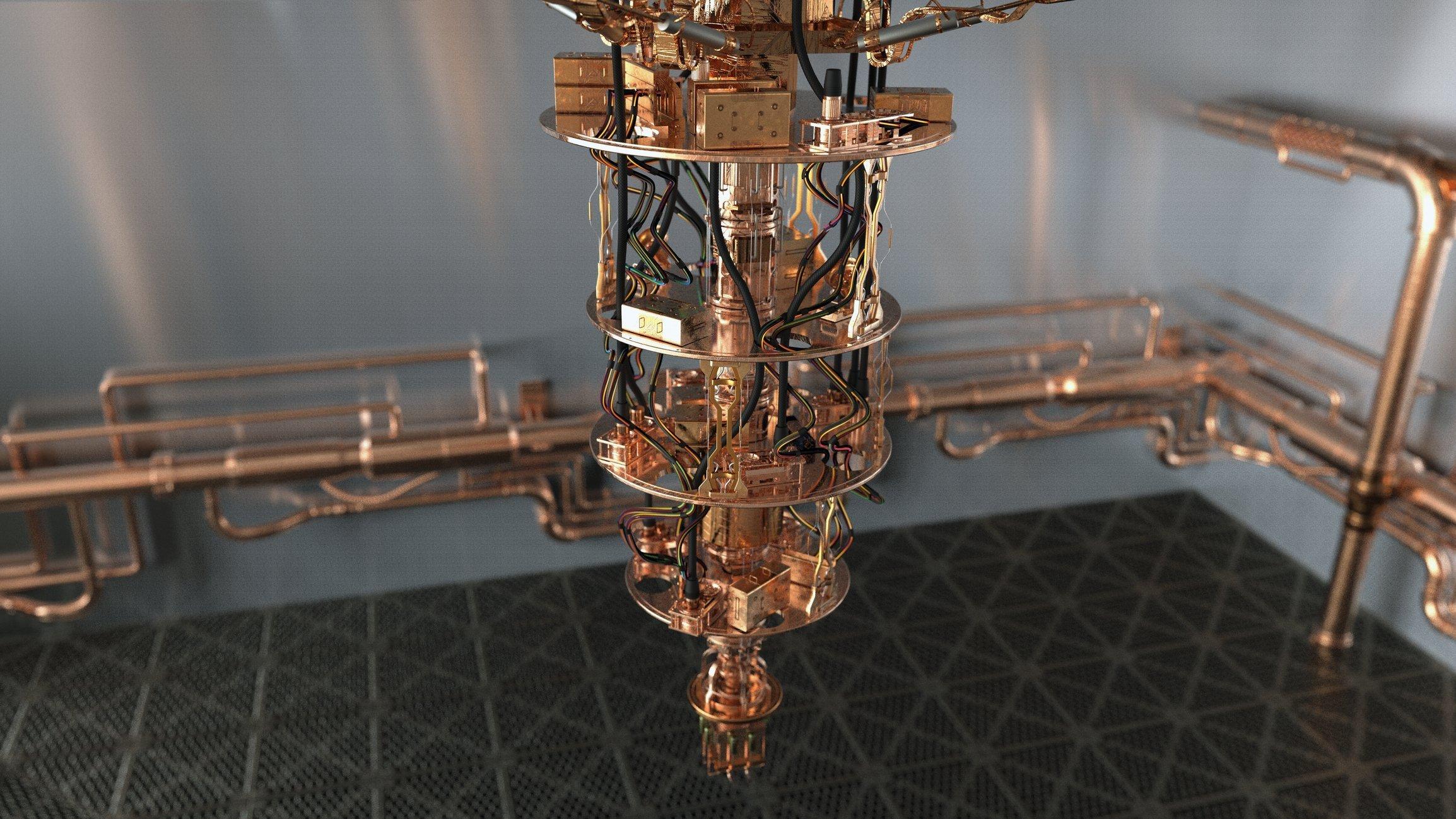

Zumindest bislang. Google hat nun eine Fehlerkorrekturschaltung entwickelt, die in einer vergrößerten Version weniger Fehler produziert als eine kleinere Version, wie die Firma im Fachmagazin Nature mitteilt. Das sei ein Meilenstein auf dem Weg zu skalierbaren, also vergrößerbaren, Quantencomputern, sagt Hartmut Neven, Leiter von Googles Quantum AI Lab, das das neue Verfahren auf Googles Quantenprozessor „Sycamore“ entwickelt hat.

In der Stärke von Quantencomputern liegt auch ihre Schwäche. Das Qubit, ihre kleinste Recheneinheit, kann eine Überlagerung der beiden Werte „0“ und „1“ speichern, anders als das Bit des klassischen Rechners, das gleichzeitig nur einen der beiden Werte aufnehmen kann. Je mehr Qubits ein Quantenrechner hat, desto mehr Information kann er parallel verarbeiten, zumindest im Prinzip. Denn schon kleinste Störungen aus der Umwelt lassen die Doppelexistenz kollabieren, ein Fehler entsteht.

Die Idee der Fehlerkorrektur ist nun, von jedem Qubit mehrere Kopien bereitzustellen, sodass geprüft werden kann, ob alle den gleichen Zustand einnehmen oder nicht. Wenn nicht, liegt ein Fehler vor, der dann korrigiert werden kann.

Für diese Prüfung braucht es aber weitere Qubits. Es entsteht eine recht komplexe Schaltung, ein so genanntes „logisches Qubit“, das aus vielen einzelnen, so genannten „physikalischen Qubits“, zusammengesetzt ist. Bei der von Google verwendeten Fehlerkorrekturmethode namens Surface-Code sind das 17 physikalische Qubits pro logischem Qubit.

Gleichzeitige Fehler verursachen großen Mehraufwand

Damit kann man allerdings nur nacheinander auftretende Fehler korrigieren. Zwei gleichzeitige Fehler treten zwar seltener auf, doch bei aufwändigeren Berechnungen fallen auch sie ins Gewicht. Ein Surface-Code, der Doppelfehler abfängt, benötigt 49 physikalische Qubits für ein einziges logisches Qubit. Wegen der hohen Fehleranfälligkeit physikalischer Qubits führte die Vergrößerung von 17 auf 49 bislang immer zu mehr Fehlern anstatt zu weniger.

Doch nun hat das Team um Hartmut Neven einen Surface-Code mit 49 Qubits hergestellt, der weniger Fehler produziert als einer mit 17. Um das zu erreichen, habe das Team das Quantencomputer-System auf allen Ebenen verbessern müssen, sagt Julian Kelly von Quantum AI: von den physikalischen Qubits über die Software, bis hin zum Kühlsystem für den Quantenchip. Beispielsweise hat das Team eine Technik genutzt, die Messfehler beim Überwachen der Daten-Qubits verringert.

„Die Qualität der Studie ist sehr gut“, lobt Andreas Wallraff von der ETH Zürich, der an ähnlichen Verfahren forscht. Erstmals sei ein „Grundpfeiler“ der Fehlerkorrektur im Experiment demonstriert worden.

Die Qubits selbst müssen besser werden und viel weniger Fehler verursachen

Wallraff weist jedoch daraufhin, das die Fehlerrate nur leicht von 3 auf 2, 9 Prozent gesunken ist. Es könne sein, dass bei weiter wachsender Zahl an physikalischen Qubits im logischen Qubit die Fehlerrate wieder zunimmt. Das wäre ein Problem: Einige avisierte Anwendungen von Quantencomputern, etwa in der Chemie, hätten einen sehr hohen Anspruch an Fehlerraten, betont der Physiker.

Die Fehlerkorrekturverfahren werden also noch deutlich mehr physikalische Qubits pro logischem Qubit benötigen. Das räumt auch Hartmut Neven ein. Ein praktisch nutzbarer Quantencomputer werde etwa 1000 logische Qubits brauchen, die aus jeweils 1000 physikalischen Qubits bestehen, sagt der Physiker, insgesamt also eine Million Qubits.

Da ist die Forschung noch lange nicht. Das nächste Ziel seien deutlich verbesserte physikalische Qubits, sagt Wallraff. „Wenn die physikalischen Qubits und die an ihnen durchgeführten Operationen um den Faktor 10 oder Faktor 100 besser werden, könnte all das anfangen, gut zu funktionieren“, schätzt der Physiker.